El grupo de investigación RSAIT de la Universidad del País Vasco (UPV/EHU) ha propuesto una aproximación para que los robots sociales tengan una expresión corporal más natural al hablar. Investigadores del grupo han utilizado redes Generative Adversarial Networks (GAN) para generar movimientos nuevos, con el fin de que el robot aprenda, y han verificado, mediante análisis estadísticos, que el robot realiza movimientos más naturales y espontáneos que con otros sistemas.

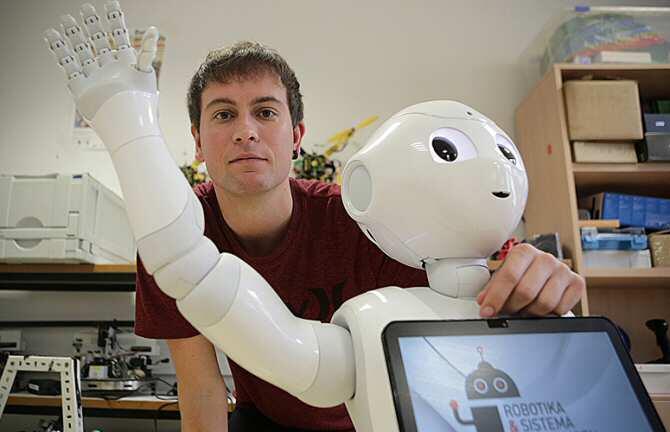

En el ámbito de la robótica social está creciendo la demanda de robots que se comporten de manera parecida a los humanos, con el fin de mejorar la interacción entre humanos y robots. El habla juega un papel fundamental en ello, así como los gestos espontáneos que se realizan al hablar, ya que refuerzan el significado de las palabras y reflejan sentimientos mediante gesticulaciones no orales. “Hasta ahora, cuando hacíamos hablar al robot, este reproducía aleatoriamente movimientos que se habían grabado previamente; tenía una espontaneidad muy limitada, por lo que decidimos crear movimientos nuevos, es decir, que el robot aprendiera de datos o movimientos que poseíamos, y fuera capaz de crear movimientos nuevos al hablar”, ha explicado Igor Rodriguez, investigador del grupo de investigación de Robótica y Sistemas Autónomos de la Facultad de Informática de la UPV/EHU.

Se han utilizado redes neuronales profundas GAN, Generative Adversarial Network, para intensificar el grado de espontaneidad. Según ha comentado Igor Rodriguez, autor principal del trabajo, “este tipo de redes se utilizan especialmente con imágenes, música y voz, para generar imágenes, música y voces nuevas. Así, decidimos emplearlas para producir movimientos nuevos; este tipo de redes GAN aprenden de datos y, después, son capaces de imitarlos, es decir, son capaces de generar cosas nuevas, muy parecidas pero nuevas”.

Rodriguez detalla que “GAN está compuesta de dos redes: una de las redes es generativa y la otra discriminativa. Mientras la generativa intenta generar cosas, la discriminativa, dado que cuenta con el conocimiento proporcionado por datos reales, es capaz de discernir si lo que se ha generado es real o no. Estas redes van evolucionando y, finalmente, la red generativa aprende a producir movimientos nuevos. Hemos integrado el modelo de esta red generativa en la arquitectura de nuestro robot, para que al hablar genere nuevos movimientos en tiempo real”.

El equipo de investigación ha comparado el sistema de generación de movimientos desarrollado con otras aproximaciones generativas, para medir cuantitativamente su idoneidad. En dicha comparativa, han analizado la naturalidad de los movimientos realizados por el robot, mediante diferentes parámetros estadísticos: vibración de los movimientos, longitud, etc. Los resultados han puesto de manifiesto que “los movimientos generados con las redes GAN son más naturales, no vibran mucho, y el robot realiza movimientos armónicos, sin grandes alteraciones”, añade el investigador. Han publicado algunos vídeos en los que se muestra la naturalidad del comportamiento del robot.

Rodriguez ha manifestado que este sistema puede ser empleado en otro tipo de robots; en definitiva, “nosotros determinamos las posiciones de los motores, y en el caso de tener que utilizar este sistema en otro tipo de robot, tendríamos que recabar datos de sus movimientos y volver a entrenar la red”. En esta investigación han trabajado en torno al habla del robot, “pero este sistema también puede utilizarse para que el robot aprenda otro tipo de movimientos”. En opinión del investigador, se trata de un pequeño avance en el campo de la robótica social. (Fuente: UPV/EHU)