Que ce soit consciencieusement ou subconsciemment, la discrimination raciale continue d’avoir un impact sérieux et mesurable sur les choix que notre société fait de la justice pénale, de l’application de la loi, de l’embauche et des prêts financiers. Il pourrait être tentant, alors, de se sentir encouragé car de plus en plus d’entreprises et d’organismes gouvernementaux se tournent vers des technologies apparemment dépaysantes pour aider certaines de ces décisions compliquées, souvent influencées par les biais. Plutôt que de s’appuyer sur le seul jugement humain, les organisations demandent de plus en plus souvent des algorithmes pour pèser sur des questions qui ont des ramifications sociales profondes, comme recruter quelqu’un pour un emploi, leur donner un prêt, les identifier comme suspects dans un crime, les envoyer à Prison ou accorder la libération conditionnelle.

Mais un nombre croissant de recherches et de critiques suggère que les algorithmes et l’intelligence artificielle ne sont pas nécessairement une panacée pour mettre fin aux préjugés, et ils peuvent avoir des répercussions disproportionnées sur des groupes qui sont déjà socialement défavorisés, en particulier les personnes de couleur. Au lieu d’offrir une solution de rechange aux biais humains, les outils que nous avons conçus pour nous aider à prédire l’avenir peuvent nous condamner à répéter le passé en reproduisant et même en amplifiant les inégalités sociétales qui existent déjà.

Ces technologies prédictives alimentées par des données ne disparaissent pas bientôt. Alors, comment pouvons-nous aborder le potentiel de discrimination dans des outils incroyablement complexes qui se sont déjà intégrés dans nos vies et dans certaines des institutions les plus puissantes du pays?

En 2014, un rapport de la Maison Blanche Obama a averti que la prise de décision automatisée « soulève des questions difficiles sur la manière de s’assurer que les effets discriminatoires résultant des processus automatisés de décision, qu’ils soient ou non intentionnels, peuvent être détectés, mesurés et corrigés ».

Au cours des dernières années, un nombre croissant d’experts ont essayé de répondre à ces questions en commençant les conversations, en développant les meilleures pratiques et les principes de la responsabilité, et en explorant les solutions pour le problème complexe et insidieux du biais algorithmique.

Penser de manière critique sur les questions de données

Bien que la prise de décision d’AI soit souvent considérée comme intrinsèquement objective, les données et les processus qui l’informent peuvent nuire de manière invisible aux systèmes qui sont destinés à être équitables. Éviter ce biais exige une compréhension de la technologie très complexe et des problèmes sociaux très complexes.

Considérons COMPAS, un algorithme largement utilisé qui évalue si les accusés et les condamnés sont susceptibles de commettre des crimes à l’avenir. Les scores de risque qu’il génère sont utilisés dans tout le système de justice pénale pour aider à prendre des décisions en matière de détermination de la peine, de mise en liberté sous caution et de libération conditionnelle.

À première vue, le COMPAS semble juste: les défendeurs blancs et noirs ayant des scores de risque plus élevés ont tendance à récidiver à peu près au même taux. Mais une analyse de ProPublica a constaté que, lorsque vous examinez les types d’erreurs commises par le système, les accusés noirs étaient presque deux fois plus susceptibles d’être mal étiquetés susceptibles de récidiver – et potentiellement traités plus sévèrement par le système de justice pénale en conséquence. D’autre part, les accusés blancs qui ont commis un nouveau crime au cours des deux années suivant leur évaluation COMPAS étaient deux fois plus susceptibles que les défendeurs noirs d’avoir été mal étiquetés à faible risque. (Le promoteur de COMPAS Northpointe – qui a récemment été nommé «Equivant» – a publié une réfutation en réponse à l’analyse de ProPublica, ProPublica, à son tour, a publié une contre-réfutation).

« Northpointe répond à la question de savoir à quel point il est précis pour les Blancs et les Noirs », a déclaré Cathy O’Neil, un scientifique de données qui a rédigé les « armes de destruction mathématique » nommées par le National Book Award. À propos de la façon dont il est inexacte pour les Blancs et les Noirs: combien de fois avez-vous mal étiqueté quelqu’un à risque?

Une question encore plus collante est de savoir si les données introduites dans ces systèmes pourraient refléter et renforcer l’inégalité sociétale. Par exemple, les critiques suggèrent qu’au moins certaines des données utilisées par des systèmes comme COMPAS sont fondamentalement entachées d’inégalités raciales dans le système de justice pénale.

«Si vous examinez le nombre de convictions d’une personne et que vous considérez comme une variable neutre – eh bien, ce n’est pas une variable neutre», a déclaré Ifeoma Ajunwa, professeur de droit qui a témoigné devant la Commission de l’égalité de l’emploi sur les implications de Big Data. « Le système de justice pénale a montré des biais raciaux systématiques ».

Les personnes noires sont arrêtées plus souvent que les blancs, même lorsqu’ils commettent des crimes aux mêmes taux. Les personnes noires sont également condamnées plus sévèrement et sont plus susceptibles de rechercher ou d’arrêter lors d’un arrêt de circulation. C’est un contexte qui pourrait être perdu sur un algorithme (ou un ingénieur) prenant ces nombres à la valeur nominale.

« L’accent mis sur la précision implique que l’algorithme recherche un véritable modèle, mais nous ne savons pas vraiment si l’algorithme trouve en fait un modèle qui est vrai de la population en général ou juste quelque chose qu’il voit dans ses données », a déclaré Suresh Venkatasubramanian, professeur informatique à l’Université de l’Utah qui étudie l’équité algorithmique.

Les données biaisées peuvent créer des boucles de rétroaction qui fonctionnent comme une sorte de biais de confirmation algorithmique, où le système trouve ce qu’il s’attend à trouver plutôt que ce qui est objectivement là-bas.

« Une partie du problème est que les gens formés comme des scientifiques de données qui construisent des modèles et travaillent avec des données ne sont pas bien connectés aux défenseurs des droits civils beaucoup de temps », a déclaré Aaron Rieke, de Upturn, un cabinet de conseil en technologie qui travaille avec les droits civils Et les groupes de consommateurs. « Ce dont je m’inquiète le plus, ce ne sont pas les entreprises qui font preuve de discrimination raciale. Je m’inquiète beaucoup plus sur les entreprises qui ne pensent pas de manière critique sur la façon dont elles pourraient renforcer le biais par la source des données qu’elles utilisent.

Comprendre ce dont nous devons réparer

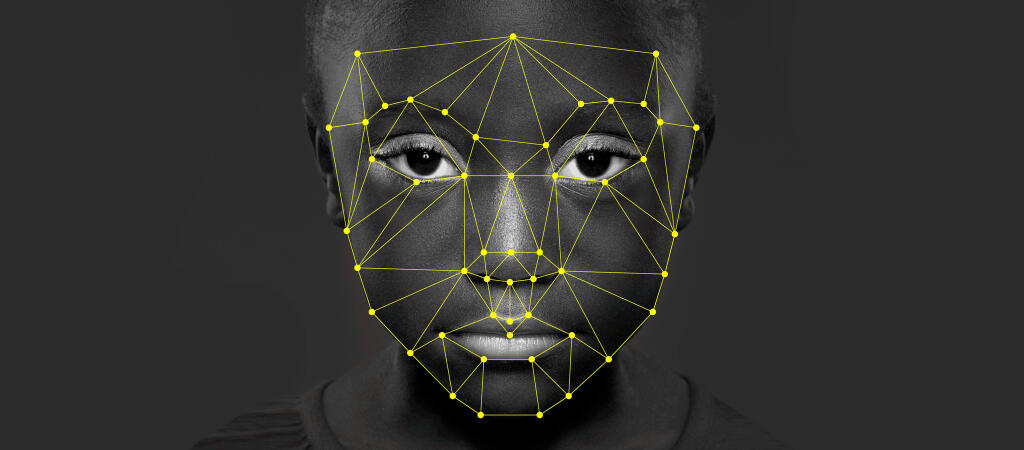

Il existe des préoccupations similaires au sujet du biais algorithmique dans la technologie de reconnaissance faciale, qui a déjà un impact beaucoup plus large que la plupart des gens se rendent compte: plus de 117 millions d’adultes américains ont été intégrés dans une base de données de reconnaissance faciale de l’agence de répression, souvent sans leur consentement Ou la connaissance, et la technologie reste largement non réglementée.

Un document de 2012, qui a été co-dirigé par un technologue du FBI, a révélé que les algorithmes de reconnaissance faciale étudiés étaient moins précis lors de l’identification des visages des personnes noires, ainsi que des femmes et des adultes de moins de 30 ans. Une découverte clé d’une étude de 2016 par Le Centre de Georgetown sur la protection de la vie privée et la technologie, qui a examiné 15 000 pages de documentation, était que «la reconnaissance par la police affecterait de manière disproportionnée les Afro-Américains». (L’étude a également fourni des modèles de politiques et de lois qui pourraient servir à réglementer la technologie à la fois fédéral et Niveaux d’état.)

Certains critiques suggèrent que la solution à ces problèmes consiste simplement à ajouter plus de diversité aux ensembles de formation, mais c’est plus compliqué que cela, selon Elke Oberg, responsable du marketing chez Cognitec, une société dont les algorithmes de reconnaissance faciale ont été utilisés par la loi, Les organismes d’application de la loi en Californie, au Maryland, au Michigan et en Pennsylvanie.

« Malheureusement, il est impossible de faire des déclarations absolues [sur la technologie de reconnaissance faciale] », a déclaré Oberg. « Toute mesure sur les performances de reconnaissance faciale dépend de la diversité des images dans la base de données, ainsi que de leur qualité et de leur quantité ».

Jonathan Frankle, un ancien technologue en personnel du Georgetown University Law Center qui a expérimenté des algorithmes de reconnaissance faciale, peut parcourir une liste de facteurs qui peuvent contribuer aux taux de réussite inégaux des nombreux systèmes actuellement utilisés, y compris la difficulté de certains Les systèmes ont pour détecter les repères faciaux sur la peau plus foncée, le manque de bons ensembles de formation disponibles, la nature complexe des algorithmes d’apprentissage eux-mêmes et le manque de recherche sur le problème. « S’il s’agissait simplement de mettre plus de personnes noires dans un ensemble de formation, ce serait une solution très simple. Mais il est intrinsèquement plus compliqué que cela. »

Il pense qu’une étude plus approfondie est cruciale pour trouver des solutions et que la recherche est des années derrière la façon dont la reconnaissance faciale est déjà utilisée. « Nous ne savons même pas très bien quels sont les problèmes que nous devons régler, ce qui est terrifiant et devrait faire marcher un chercheur », a déclaré Frankle.

Le gouvernement pourrait intervenir

Les nouvelles lois et une meilleure réglementation gouvernementale pourraient constituer un outil puissant pour réformer la façon dont les entreprises et les organismes gouvernementaux utilisent l’AI pour prendre des décisions.

L’année dernière, l’Union européenne a adopté une loi appelée «Règlement général sur la protection des données», qui comprend de nombreuses restrictions sur le traitement automatisé des données personnelles et nécessite une transparence sur «la logique impliquée» dans ces systèmes. Une réglementation fédérale semblable ne semble pas être disponible aux États-Unis – la FCC et le Congrès poussent à bloquer ou à démanteler les protections fédérales en matière de protection des données – bien que certains États, y compris l’Illinois et le Texas, ont adopté leurs propres lois biométriques de confidentialité pour protéger le type Des données personnelles souvent utilisées par des outils de prise de décision algorithmique.

Cependant, les lois fédérales existantes protègent contre certains types de discrimination, en particulier dans des domaines tels que l’embauche, le logement et le crédit, bien qu’ils n’aient pas été mis à jour pour aborder la façon dont les nouvelles technologies se croisent avec de vieux préjugés.

«Si nous utilisons un algorithme de détermination de la prédiction où nous ne pouvons pas interroger les facteurs utilisés ou un algorithme de notation de crédit qui ne peut pas vous dire pourquoi vous avez refusé le crédit – c’est un endroit où une bonne réglementation est essentielle [ Parce que] ce sont des problèmes de droits civils « , a déclaré Frankle. « Le gouvernement devrait intervenir ».

Transparence et responsabilité

Un autre domaine clé où le gouvernement pourrait être utile: faire preuve de plus de transparence quant à la façon dont ces outils prédictifs influents atteignent leurs décisions.

« Les seules personnes qui ont accès à cela sont les personnes qui les construisent. Même la police n’a pas accès à ces algorithmes « , a déclaré M. O’Neil. « Nous nous rendons au courant de la façon de contrôler nos rues à des gens qui ne nous diront pas comment ils le font ».

Frustré par le manque de transparence sur le terrain, O’Neil a commencé une entreprise pour aider à jeter un coup d’oeil à l’intérieur. Son cabinet de conseil effectue des audits algorithmiques et des évaluations des risques, et il travaille actuellement sur un manuel pour les chercheurs de données qui souhaitent «faire de la science des données correctement».

Complication de toute poussée vers une plus grande transparence est l’augmentation des systèmes d’apprentissage par machine, qui sont de plus en plus impliqués dans les décisions concernant l’embauche, les prêts financiers et la police. Parfois décrites comme des «boîtes noires», ces modèles prédictifs sont si complexes que même les personnes qui les créent ne peuvent pas toujours dire comment elles arrivent à leurs conclusions.

« Beaucoup de ces systèmes algorithmiques s’appuient sur des réseaux de neurones qui ne sont pas vraiment transparents », a déclaré le professeur Alvaro Bedoya, directeur exécutif du Centre sur la protection de la vie privée et de la technologie au droit de Georgetown. « Vous ne pouvez pas regarder sous le capot, parce qu’il n’y a rien à regarder sous le capot ». Dans ces cas, Bedoya a dit, il est important d’examiner si les résultats du système affectent différents groupes de différentes façons. « De plus en plus, les gens appellent à une responsabilisation algorithmique », au lieu de comprendre le code « , de faire un test rigoureux de ces systèmes et de leurs résultats, pour voir si les sorties sont biaisées ».

Qu’est-ce que l’équité signifie?

Une fois que nous passons au-delà des discussions techniques sur la façon de traiter le biais algorithmique, il y a un autre débat délicat: comment enseignons-nous des algorithmes pour évaluer la justesse et l’exactitude? Et qu’est-ce que nous décidons de «précision» et «équité»? Si nous voulons qu’un algorithme soit plus précis, quel type de précision choisissons-nous est le plus important? Si nous voulons que cela soit plus juste, à qui sommes-nous les plus concernés par le traitement équitable?

Par exemple, est-il plus injuste pour un algorithme tel que COMPAS de mal étiqueter quelqu’un comme un risque élevé et de les pénaliser injustement plus sévèrement, ou de mal étiqueter quelqu’un à faible risque et peut-être plus facile de commettre un autre crime? L’AURA, un outil algorithmique utilisé à Los Angeles pour aider à identifier les victimes de mauvais traitements infligés aux enfants, est confronté à un dilemme pareillement épineux: lorsque la preuve n’est pas claire, comment un système automatisé doit-il peser le préjudice de prendre accidentellement un enfant contre les parents qui ne sont pas abusifs contre Le mal de laisser involontairement un enfant dans une situation abusive?

« Dans certains cas, la prédiction la plus précise peut ne pas être la plus souhaitable sur le plan social, même si les données sont impartiales, ce qui est une énorme hypothèse – et ce n’est souvent pas », a déclaré Rieke.

Les avocats disent que la première étape est de commencer à exiger que les institutions utilisant ces outils prennent des choix délibérés sur les décisions morales intégrées dans leurs systèmes, plutôt que de transférer la responsabilité à la fausse neutralité des données et de la technologie.

« Ce ne peut être qu’une solution technologique seule », a déclaré Ajunwa. « Tout cela revient à avoir un élément de discrétion humaine et ne pense pas que toutes les questions difficiles peuvent être répondues par la technologie ».

D’autres suggèrent que la prise de décision humaine est si encline à un biais cognitif que les outils axés sur les données pourraient être le seul moyen de l’anticiper, en supposant que nous pouvons apprendre à mieux les bâtir: en étant consciencieux, en étant transparent et en faisant face ouvertement aux préjugés de Le passé et le présent dans l’espoir de ne pas les coder dans notre avenir.

« Les algorithmes ne font que répéter notre passé, donc ils n’ont pas l’innovation morale pour essayer d’améliorer notre vie ou notre société », a déclaré O’Neil. « Mais tant que notre société est elle-même imparfaite, nous devrons ajuster quelque chose pour supprimer la discrimination. Je ne suis pas partisan de revenir à la prise de décision purement humaine parce que les humains ne sont pas géniaux. … Je pense que les algorithmes ont le potentiel de faire mieux que nous. »Elle s’arrête pour un moment. « Je pourrais changer d’avis si vous me le demandez dans cinq ans, cependant ».

La Source: http://53eig.ht/2uMS4Kk