Steve Thomas et moi parlons d’implants cérébraux. Le film Out Out For a Hero de Bonnie Tyler joue en arrière-plan et, un instant, j’oublie presque qu’une maladie a volé à Steve son discours. La conversation se brise brièvement; maintenant je vois son fauteuil roulant, son ventilateur, son lit d’hôpital.

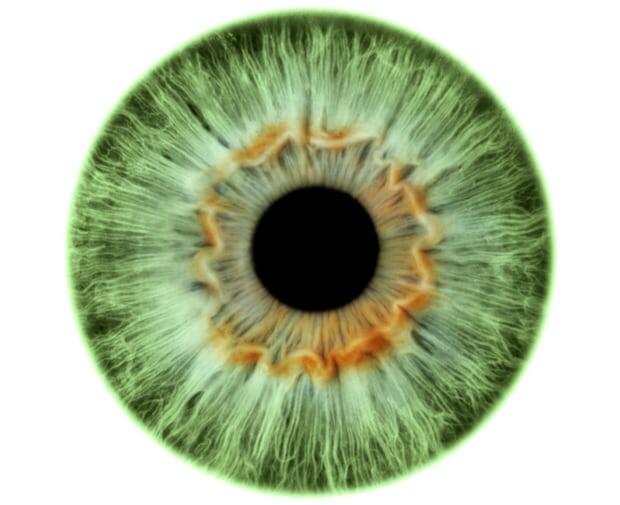

Steve, un ingénieur en logiciel, a reçu un diagnostic de SLA (sclérose latérale amyotrophique, un type de maladie du motoneurone) âgé de 50 ans. Il savait que c’était progressif et incurable; qu’il deviendrait bientôt incapable de bouger et, dans son cas, parlerait. Il utilise la technologie eye-gaze pour me le dire (et plus tard pour désactiver le son de Bonnie Tyler); les caméras captent la réflexion de la lumière de ses yeux alors qu’il scanne un écran. Les mouvements de ses pupilles sont traduits en mouvements d’un curseur par la technologie infrarouge et le curseur choisit des lettres ou des symboles. Un dispositif générateur de parole transforme ces mots écrits en paroles – et, à son tour, des phrases et des histoires se forment.

Les appareils oculaires permettent à certaines personnes ayant des mouvements limités de la parole ou de la main de communiquer, d’utiliser des commandes environnementales, de composer de la musique et de peindre. Cela inclut les patients atteints de SLA – jusqu’à 80% ont des difficultés de communication, la paralysie cérébrale, les accidents vasculaires cérébraux, la sclérose en plaques et les lésions de la moelle épinière. C’est loin d’être le rédacteur en chef d’Elle, Jean-Dominique Bauby, enfermé par un coup en 1995, clignotant laborieusement à travers des lettres sur un tableau d’alphabet. Ses mémoires, écrits à un mot toutes les deux minutes, devinrent plus tard un film, The Diving Bell et le papillon. Bien que certains utilisent encore des options peu technologiques (tout le monde ne peut pas répondre aux exigences physiques ou cognitives des systèmes oculaires, parfois les patients enfermés peuvent cligner des yeux mais ne bougent pas les yeux), de la parole au texte et de la synthèse vocale la fonctionnalité sur les smartphones et les tablettes a révolutionné la communication.

La technologie Eye-gaze a également évolué rapidement avec des options open source et à moindre coût, un financement solide du NHS et une meilleure accessibilité – certains utilisateurs n’ont pas plus de 13 mois. Des prototypes récents ont implanté une technologie similaire dans les smartphones et les lunettes. Mais en pratique, même certains systèmes plus récents ne permettent que huit mots par minute. Des problèmes techniques au cours de ma visite signifient que Steve atteint 3 mots par minute – notre taux de conversation moyen dans la conversation fluide est de 190 mots par minute. «Le regard me permet de faire n’importe quoi depuis Skype ma femme pour jouer à des jeux», dit-il, «mais l’inconvénient est que parfois je ne peux pas vraiment participer à des conversations.

Publicité

Pourtant, Steve sonne toujours comme Steve. Il a conservé son discours avant de disparaître grâce à la banque vocale, enregistrant environ 1 500 phrases. Maintenant, son dispositif de communication génère un nombre infini de phrases à partir de ces sons, son identité préservée d’une manière ou d’une autre. Les prix commencent à environ £ 100 pour les services de banque vocale; certains organismes de bienfaisance offrent des prêts d’équipement et un soutien financier.

Aux Pays-Bas, Peter Desain, responsable de l’intelligence artificielle à l’Institut Donders pour le Cerveau, la Cognition et le Comportement, étudie les interfaces cerveau-ordinateur (BCI), une technique d’analyse des signaux cérébraux. BCI a récemment permis à trois patients paralysés ailleurs de taper avec leurs pensées à travers des implants cérébraux. Ce système, encore en développement précoce, est lent (2-8 mots par minute), coûteux et peut prendre des mois à apprendre.

Mais la méthode NoiseTag de Desain, développée à Radboud University Nijmegen, ne nécessite pas d’intervention chirurgicale. Au lieu de cela, les utilisateurs portent un casque équipé d’électrodes qui enregistrent l’activité cérébrale. Ils regardent un écran avec une matrice de caractères clignotants, chacun étiqueté avec un code spécifique. La focalisation sur un personnage donné fait apparaître sa signature dans les ondes cérébrales enregistrées par le casque; le caractère correspondant est tapé, puis un périphérique « parle » une phrase terminée. Le système exploite l’apprentissage automatique et prédit la réponse d’un utilisateur pour chaque modèle; cela signifie qu’un calibrage limité, le cas échéant, est nécessaire – une lettre peut être tapée toutes les une ou deux secondes avec une précision de 95%. Vingt patients atteints de SLA sont en train de tester la technologie, avec un spin-off visant à augmenter les chiffres au cours de la prochaine année et étendre la méthode à l’Internet des objets (IoT).

Récemment, Facebook a annoncé son entrée dans l’anneau BCI, prêt à décoder l’activité neuronale dans les deux ans en utilisant une technique non invasive à développer au mystérieux Building 8 à Menlo Park en Californie. Mark Zuckerberg croit que nous allons bientôt dactylographier en utilisant seulement nos pensées à cinq fois la vitesse actuellement gérée sur les smartphones. De plus, Elon Musk vient de fonder la société NeuraLink, dont le chiffre d’affaires s’élevait à 100 millions de dollars, et nous affirmons que nous bénéficierons tous de sa technologie BCI d’ici une dizaine d’années. D’autres expriment un scepticisme sain; la bande passante et la biocompatibilité demeurent des défis importants, sans parler des risques chirurgicaux et de notre compréhension des principes neuroscientifiques en constante évolution.

Aux États-Unis, Darpa a également investi 65 millions de dollars dans des implants neuronaux pour rétablir la parole, l’ouïe, la vision et la mémoire chez les personnes ayant un traumatisme cérébral et une maladie neurodégénérative. Un groupe travaille à l’enregistrement sans fil des signaux d’un maximum de 1m de neurones (actuellement, le BCI lit environ 100 neurones) en implantant des dizaines de milliers de microdispositifs appelés neurograines à travers le cerveau. Cet «intranet cortical» va lire et écrire dans l’information – l’amélioration du cerveau pourrait suivre. Les neuroprothèses ont déjà montré leur potentiel pour améliorer la mémoire chez le rat et la prise de décision chez le singe; les humains sont une autre affaire, bien sûr. C’est peut-être la raison pour laquelle Kernel, une start-up de 100 millions de dollars qui vise à construire «la première neuroprothèse au monde à améliorer l’intelligence humaine», a rapidement changé d’orientation. Le fondateur Bryan Johnson affirme que le BCI envahissant «est vraiment intéressant, mais pas un point d’entrée» dans une entreprise commercialement viable.

Pendant ce temps, Facebook a cherché à atténuer les inquiétudes concernant la vie privée et le piratage du cerveau: « Il ne s’agit pas de décoder des pensées aléatoires. Il s’agit de décoder les mots que vous avez déjà décidé de partager en les envoyant au centre de votre cerveau. Pensez-y comme ceci: vous prenez beaucoup de photos et choisissez de n’en partager que quelques-unes. De même, vous avez beaucoup de pensées et choisissez de ne partager que certaines d’entre elles. « Bien sûr, les photos non destinées au partage ne restent pas toujours non partagées …

« J’ai déjà un prototype BCI », raconte Steve. «Mon désir de mort est quand je ne réponds même pas avec BCI.» Ses mots évoquent quelque chose écrit par Bauby, pleurant la perte de la vraie conversation: «La douce Florence refuse de me parler à moins que je ne respire bruyamment dans le récepteur que Sandrine tient collé à mon oreille. «Es-tu là, Jean-Do?» Demande-t-elle anxieusement par-dessus l’air. Et je dois admettre que parfois je ne sais plus. »

Pour beaucoup comme Steve, la technologie de la communication ne concerne pas le perfectionnement du cerveau sophistiqué; c’est simplement de l’existence.

La Source: http://bit.ly/2zrrPYY