Investigadores del Centro de Visión por Computador de la Universidad Autónoma de Barcelona (CVC-UAB) (Catalunya, España), junto al Intel Computing Visual Lab, han creado un entorno virtual de código abierto y gratuito para desarrollar, entrenar y validar la conducción autónoma desde el punto de vista de la inteligencia artificial. Su nombre, CARLA.

Forzar las situaciones más extrañas o difíciles de la conducción es el objetivo final de este simulador, que permite generar diversas situaciones de conducción para que el coche ‘aprenda’ cómo tiene que reaccionar: la luz del ocaso, un accidente a pocos metros o un vehículo circulando en contra dirección, por ejemplo.

“CARLA nos permite conducir en diferentes entornos, condiciones de luz, cambios en la meteorología o escenarios urbanos”, explica Antonio López, uno de los investigadores principales. Para ello, se han recogido datos de conductores reales dentro del entorno, dándole al vehículo un modelo al cual imitar.

Sus ventajas incluyen una reducción de las limitaciones físicas de entrenar un coche en un entorno real (una ciudad), con los riesgos que ello implicaría, así como una rebaja sustancial en recursos y fondos. Además, un solo coche está lejos de poder compilar los datos suficientes para cubrir la multitud de casos o situaciones que deben ser procesadas por un vehículo autónomo.

CARLA también proporciona al automóvil el acceso a información privilegiada como velocidad, aceleración y datos detallados sobre distintas infracciones (colisiones, invasión de carril opuesto, salida de la carretera, etc.), así como la posición de todos los participantes del tráfico.

Actualmente, la tecnología de los videojuegos ya es extensamente empleada para entrenar a los coches autónomos. Aun así, los simuladores de conducción de código abierto y gratuito son muy limitados y carecen de muchos de los elementos básicos e imprescindibles para una experimentación flexible y realista, como puede ser la inclusión de peatones, de señales de tráfico, intersecciones u otras complicaciones que pueden surgir durante la conducción real.

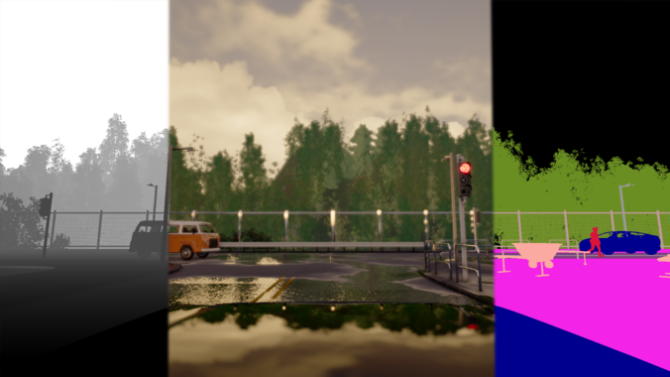

En este momento los sensores incluidos en CARLA son cámaras RGB y pseudo-sensores de profundidad y de segmentación semántica. Los parámetros de la cámara incluyen la localización 3D, la orientación 3D con respecto al sistema de coordenadas del coche, campo de visión y profundidad.

El sensor de profundidad es denso y de rango ajustable. El sensor de segmentación semántica provee doce clases semánticas: carretera, líneas divisorias, señales de tráfico, acera, vallas, postes, muros, edificios, vegetación, vehículos, peatones y otros. Pronto se incorporarán nuevos sensores como el LIDAR.

El simulador no solo recrea el mundo dinámico, sino que también provee de una interfaz simple entre el mundo y el agente que interactúa con él. La plataforma tiene un entorno altamente realista y permite a los usuarios usar una serie de sensores para el guiado del coche.

El proyecto fue presentado en la First Conference in Robot Leaning de Mountain View, California. Los investigadores esperan que CARLA, de código abierto y gratuito, sirva para que una amplia comunidad participe activamente en la investigación de la conducción autónoma. (Fuente: UAB)